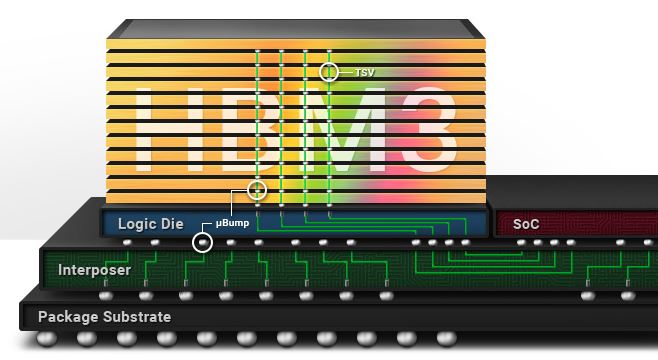

HBM 은 High Bandwidth Memory의 약자이며 직역하면 ‘광 대역폭 메모리’가 된다. 대역폭이란 결국 단위 시간 당 주고받을 수 있는 데이터의 양을 뜻한다. 데이터 버스의 수를 크게 늘리고 메모리 면을 수직으로 쌓아 올려 데이터의 입출력을 크게 늘린 ‘광 대역폭 메모리’ 를 말한다. HBM 은 보통 CPU 나 GPU 와 같은 처리장치 바로 옆에 위치하여 하나의 칩으로 패키지 화 된다. 2023년 두 국내 회사가 세계 시장을 양분하고 있다.

ChatGPT 등 AI 서비스가 활성화되면서 각국에서는 AI 가속 처리 장치의 개발이 치열해 지고 있다. AI는 원리 상 엄청난 데이터의 학습과 그 결과를 저장하여야 하므로, 그 성능은 사용하는 메모리의 대역폭에 크게 의존하게 된다. 큰 대역폭 때문에 기존의 메모리 칩처럼 하나의 독립된 제품으로 나오는 게 아니라, 주로 CPU, GPU, AI 처리장치 옆에 붙여 하나의 칩으로 만든다.

HBI 기술 현황 (2023년 기준)

SK 하이닉스 의 HBM 3는 12개의 DRAM 을 수직으로 쌓아서 16~64GB의 밀도와 819GB/s의 속도를 구현하였다 (2021년). 삼성전자 의 HBM 3 역시 24GB의 밀도와 819GB/s의 속도를 구현하였는데, 이러한 고 밀도를 구현하기 위해서는 열을 잘 방출해야 하고 데이터의 에러를 복구할 수 있는 고 난이도의 기술이 필요하다. 양 사 모두 2023년 현재 대량 생산이 가능하다.

참고로 PC에서 많이 사용되고 있는 DDR5 의 경우에 속도는 1GB/s 정도이다.

관련 이슈 (2023년 기준)

- SK 하이닉스 와 삼성전자 가 세계 HBM 시장을 양분하고 있다.

- AI 산업의 폭발적 성장으로 위의 두 회사는 대박이 날 것 같다.

- HBM 이 기존 DRAM 메모리 상품들을 당장 대치할 수 있는 것은 아니다.